Musik verbinden wir mit Menschen, unseren Lieblingsbands und Künstler/innen. Doch schon jetzt rücken Maschinen in den Vordergrund, die autonom ihre eigene Musik komponieren und produzieren können. Werden somit Menschen bei der Musikproduktion überflüssig?

Künstliche Intelligenz. Ein Begriff, welchen man nicht direkt mit Musik in Verbindung bringt. Aber die Chance ist groß, dass ihr schon ein Lied gehört habt, an dem nicht nur Menschen, sondern auch Computer gearbeitet haben. Das kann von der intelligenten Unterstützung beim Abmischen eines Songs bis zur kompletten Eigenkomposition reichen. Um das Konzept begreifbarer zu machen, werde ich einige Projekte vorstellen, in denen KI eine Rolle spielt. Beginnen wir mit dem Projekt Blob Opera von Google Arts&Culture.

Blob Opera

Dieses Bild dürfte einigen bekannt vorkommen. Auf Youtube oder TikTok werden immer wieder diese vier „Blobs“ gezeigt, welche als Chor Lieder singen. Direkt zu Beginn wird man mit dem ersten Blob in Kontakt gebracht. Wenn man diesen durch Ziehen verformt, animiert man ihn so zum Singen. Nach und nach werden dann die anderen Blobs vorgestellt, bis das Quartett aus Bass, Tenor, Mezzosopran und Sopran vollständig ist. Nun kann man sich einen Blob mit der Maus oder dem Finger greifen und ihn verformen. Dabei ändert die Y-Achse die Tonhöhe und die X-Achse den Vokal. Natürlich singt dieser Blob dann nicht alleine, sondern die künstliche Intelligenz (KI) sorgt dafür, dass die anderen ihn harmonisch unterstützen. Diese singen dann autonom die passenden Töne, sodass sich spannende Harmonien und Wechsel ergeben.

Wie funktioniert Blob Opera?

Vier Opernsänger verliehen den einzelnen Blobs ihre Stimmen. Mit den Tonaufnahmen wurden durch maschinelles Lernen vier Sprachmodelle erzeugt, die nun in Echtzeit diese Stimmen synthetisch erzeugen können. Also hört man nicht direkt die Aufnahmen, sondern einen Algorithmus, der die Stimmen der Sänger imitiert. Dadurch können alle Parameter wie Tonhöhe, Tonlänge, Silben und Charakter frei bestimmt werden, obwohl die Sänger das nie genau so eingesungen haben.

Auch wenn dieses Projekt sehr beeindruckend ist und es Nutzer/innen ohne Vorkenntnisse ermöglicht, eine realistisch klingende Performance zu erschaffen, würden wir uns das Ergebnis wahrscheinlich weder auf Spotify noch als Soundtrack in einem Film anhören. Dafür gibt es kommerzielle Lösungen wie AIVA AI.

AIVA

AIVA, kurz für Artificial Virtual Intelligent Artist spezialisiert sich auf die Komposition von Soundtracks für Filme, Spiele oder Videos. Dieses Programm erzeugt auf der Basis einer gewünschten Voreinstellung ein fertiges, originelles Musikstück.

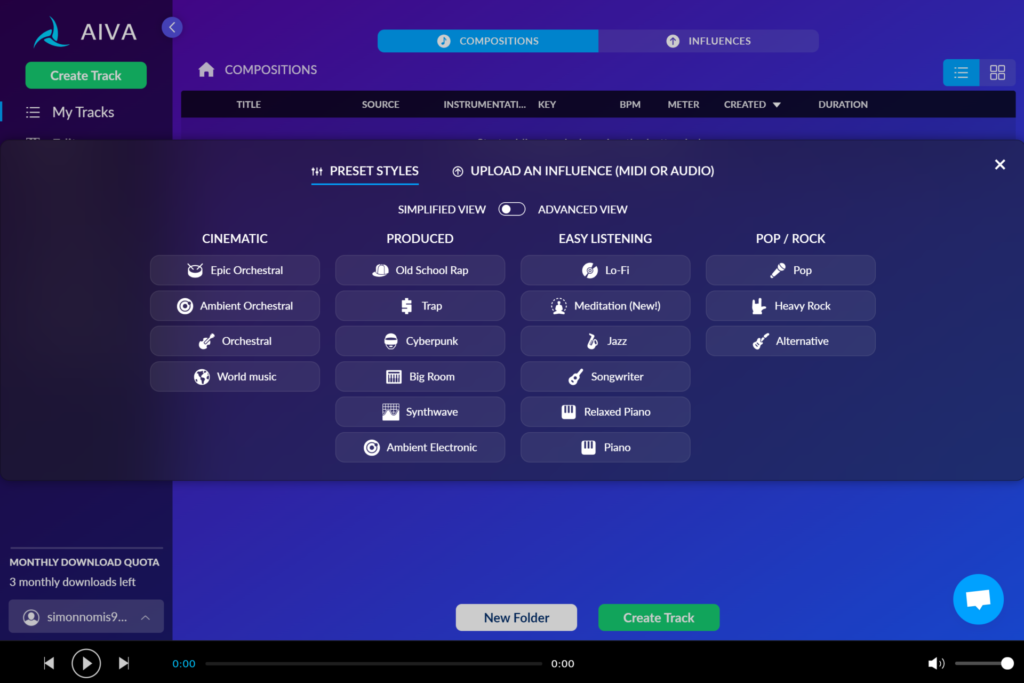

Der Weg zur Erstellung eines Musikstücks dauert nur wenige Minuten und findet auf der Website statt. Nachdem ihr euch einen Account erstellt habt, erscheint direkt der Button „Create Track“. Daraufhin muss nur noch das gewünschte Genre ausgesucht und auf Create geklickt werden. Nach ein paar Sekunden steht das generierte Lied zum Anhören bereit. Wahlweise könnt ihr davor ein paar Parameter ändern oder danach das Lied in einem Editor bearbeiten. Dieser ähnelt DAWs (Digital Audio Workstation) wie Logic Pro von Apple oder Ableton und ermöglicht das grundlegende Verändern des erstellten Songs. Wenn ihr euch an einem schon bestehenden Lied orientieren möchtet, könnt ihr die MIDI Dateien hochladen und es wird ein neues, aber ähnlich klingendes Lied erstellt.

Wie funktioniert AIVA?

AIVA basiert auf Machine Learning, genauer Deep Learning. Dabei wurden dem Programm die Noten von über 30.000 Stücken gegeben, welche dann auf Ähnlichkeiten und Strukturen untersucht wurden. Außerdem werden die Stücke in verschiedene Kriterien eingeteilt, wie: Anzahl der Notendichte, Emotion oder Art der Instrumente. Dadurch versteht AIVA die Musik und kann ähnliche Strukturen neu erschaffen.

Das Ziel von AIVA sei nicht das Ersetzen von Menschen, sondern das Ergänzen. Damit ihr beispielsweise für ein Videospiel nicht mehrere Stunden Musik selbst komponieren müsst, kann die KI den Stil von nur einigen wenigen Liedern aufgreifen und diese durch neue ergänzen. Ein ähnliches Problem löst Eternal Jukebox mit einer anderen Methode.

Eternal Jukebox

Einen Song zu analysieren und endlos abzuspielen, ohne dass er sich wiederholt, ist der Gedanke hinter der Website. Durch berechnete Verknüpfungen zwischen Teilen des Songs, kann im Lied hin und her gesprungen werden.

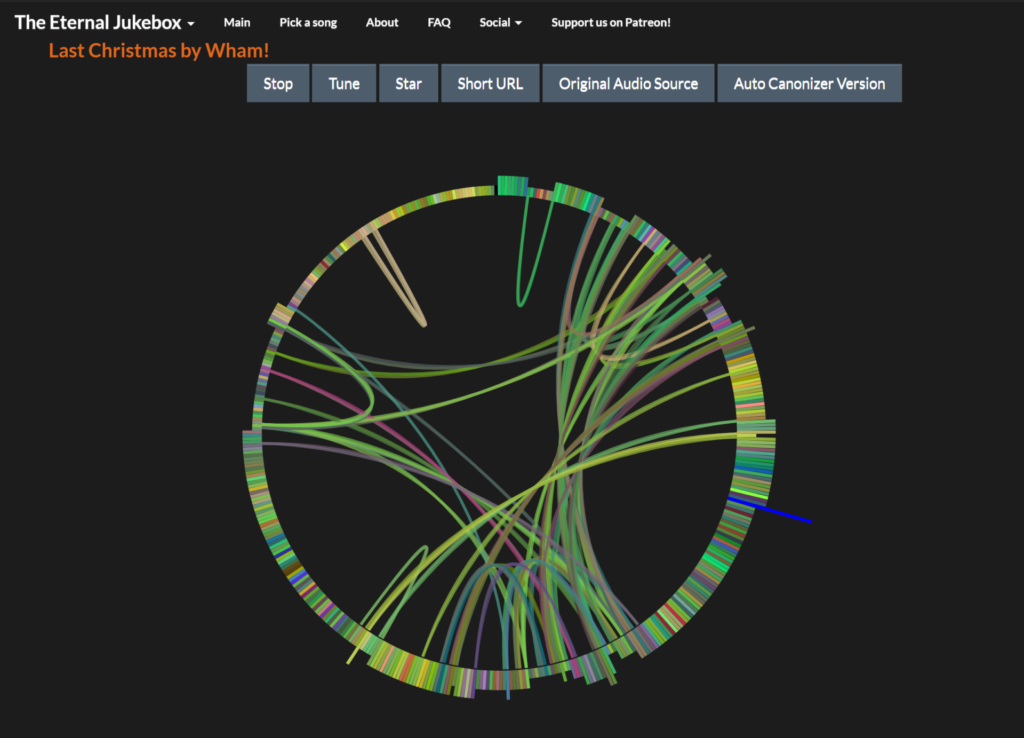

Der Albtraum: Last Christmas in der Endlosschleife. Eternal Jukebox sorgt dafür, dass sich das Lied nicht einfach wiederholt, sondern intelligent an ähnlich klingende Stellen springt, sodass das Lied nie endet. Auf der Website könnt ihr auf fast alle streambaren Lieder zugreifen und euch eines davon aussuchen, das die KI analysieren soll. Anschließend kann man sich das fertige Netzwerk bis in alle Ewigkeit anhören.

Wie funktioniert Eternal Jukebox?

Nachdem das Lied geladen wurde, wird es in seine Takte getrennt. Jede Einheit wird unter anderem auf Lautstärke, Tonhöhe und Position geprüft und mit ähnlichen Takten verbunden. So entscheidet sich das Programm an diesen Punkten, ob es an eine andere Position springt um eine Variation zu kreieren.

Ob dieses Programm nützlich sein kann, muss jeder selbst entscheiden. Aber wie schon erwähnt ist es vorstellbar, dass existierende Lieder hiermit künstlich verlängert werden, ohne das man eine eindeutige Wiederholung feststellen kann. Ein möglicher Verwendungszweck wäre hierbei als Hintergrundmusik in Spielen. Wenn nur ein Lied oder wenige Lieder vorhanden sind, sorgt das Programm für mehr Variation, ohne selbst neue Lieder zu schreiben.

iZotope

Zuletzt möchte ich noch auf das Unternehmen iZotope eingehen, deren Produkte heute schon in vielen Musikproduktionen eine wichtige Rolle spielen. Vor Allem das Plugin „Ozone“ hat die Arbeit vieler Musikschaffenden erleichtert.

Ozone hilft am Ende der Produktion, wenn das Lied fertig komponiert, aufgenommen und gemischt ist. Normalerweise sorgt man selbst dann dafür, dass sich die Frequenzen, Lautstärken und die Dynamik in einem angemessenen Rahmen befinden. Dafür müssen sämtliche Parameter verschiedener Werkzeuge manuell und zeitraubend eingestellt werden. Das Plugin übernimmt einen Großteil dieser Aufgaben automatisch. Einzustellen sind dann nur noch wenige Parameter, auf denen dann die Entscheidungen des Programms basieren. Am Ende hat man mit wenigen Klicks ein fertig gemastertes Lied, was sonst mehrere Stunden dauern könnte.

Um zu erfahren wie das Programm funktioniert und mehr darüber zu lesen, verlinke ich den Beitrag von Jonas Waschke über die Produkte von iZotope.

Fazit

Werden Künstler/innen und Tontechniker/innen jetzt überflüssig? Nein. Dafür ist die künstliche Intelligenz noch zu schwach. Die meisten sind eher Spielzeuge, denen man gut zuhören kann, die aber keine professionellen Ansprüche erfüllen. Die wenigen, die tatsächlich kommerziell verwendet werden, funktionieren unterstützend und erleichtern die Arbeit. Dass eine KI bald den Ansprüchen von professioneller Musikproduktion gerecht wird und Arbeitsplätze unnötig macht, bezweifle ich. Musik ist immer subjektiv und kann nicht von einer Maschine gelernt werden. Auch die menschlichen Facetten, die Musik so sehr prägen, werden vorerst für Maschinen nicht erreichbar sein.

Weitere interessante Projekte:

Quellen

https://artsandculture.google.com/experiment/blob-opera/

https://coolsten.de/blob-opera-google-arts-and-culture/

https://www.pcwelt.de/a/aiva-die-kuenstliche-intelligenz-komponiert-die-musik-der-zukunft,3450745

https://eternalbox.dev/jukebox_index.html

https://www.izotope.com/en/learn/how-to-use-master-assistant-in-ozone.html